Como algumas das maiores empresas do planeta já usam inteligência artificial para monitorar conversas de funcionários

Nomes conhecidos como Nestlé, AstraZeneca e Walmart se valem da ferramenta para identificar “comportamentos nocivos” no ambiente de trabalho; especialistas veem risco

A vida real está cada vez mais parecida com a distopia de George Orwell. Com o surgimento da inteligência artificial, a história vem ganhando novos capítulos. Agora, as empresas deram mais um passo e estão utilizando IA para monitorar as conversas dos funcionários — em uma espécie de versão corporativa do Grande Irmão do clássico 1984.

A Aware, companhia especializada em uso da inteligência artificial para monitoramento de mensagens, revelou que grandes empresas estão usando sua tecnologia.

Entre os clientes da Aware estão nomes conhecidos, como Nestlé, AstraZeneca, Walmart, Delta, T-Mobile, Chevron e Starbucks.

A companhia de monitoramento informou que Walmart, T-Mobile, Chevron e Starbucks usam o software para risco de governança e conformidade. Esse tipo de trabalho representa cerca de 80% dos negócios da empresa.

A fiscalização de mensagens em ambiente de trabalho não é novidade e já era realizada através do e-mail. Porém, agora, ela é feita pela inteligência artificial e pode ser realizada em outras plataformas conhecidas no meio corporativo, como o Microsoft Teams.

O setor de vigilância de funcionários vem crescendo após a criação do ChatGPT, da OpenIA, em 2022, o que vem refletindo na receita da Aware.

Leia Também

Nos últimos cinco anos, a empresa registrou aumento médio de 150% ao ano na receita, de acordo com o cofundador e CEO da startup, Jeff Schumann.

- VEJA TAMBÉM: PODCAST TOUROS E URSOS - O ano das guerras, Trump rumo à Casa Branca e China mais fraca: o impacto nos mercados

Inteligência artificial para monitorar: como funciona a tecnologia da Aware

Para eliminar a necessidade de relatórios para entender a reação dos trabalhadores às políticas da empresa, o software da Aware realiza uma leitura do sentimento dos funcionários em tempo real.

Assim, os clientes conseguem ver como os funcionários de uma determinada faixa etária ou região estão respondendo a uma nova política corporativa ou campanha.

Os modelos de inteligência artificial da Aware também conseguem identificar bullying, assédio, discriminação, pornografia, nudez e outros comportamentos nocivos dentro do ambiente de trabalho.

Segundo o CEO, a ferramenta analítica da Aware não tem a capacidade de sinalizar nomes individuais de funcionários. Contudo, sua ferramenta separada, eDiscovery, consegue.

As informações da eDiscovery são repassadas em caso de ameaças extremas ou outros comportamentos de risco predeterminados pelo cliente.

Um representante da AstraZeneca afirmou que a empresa usa o software, mas não utiliza as análises para monitorar o sentimento ou a toxicidade.

Já a Delta disse à CNBC que usa as análises e eDiscovery da Aware para monitorar tendências e sentimentos. O intuito da empresa seria coletar feedback de funcionários e de outras partes interessadas.

Toda semelhança não é mera coincidência

A Aware não é a primeira empresa de Schumann que remete à obra de George Orwell. Em 2005, ele fundou a BigBrotherLite.com, que desenvolveu um software que “aprimorou a experiência de visualização digital e móvel” do reality show Big Brother.

Contudo, com a Aware, criada em 2017, Schumann foi além. Todos os anos, a empresa publica um relatório que agrega informações sobre milhões de mensagens enviadas através de grandes empresas. Em 2023, o número era de 6,5 milhões de registros.

“Ele está sempre monitorando o sentimento dos funcionários em tempo real e sempre monitorando a toxicidade em tempo real”, disse Schumann à CNBC.

Apesar de o CEO afirmar que a inteligência artificial não identifica nomes para proteger a privacidade, um estudo já comprovou que a medida não é eficaz.

Segundo uma pesquisa sobre privacidade de dados utilizando informações do Censo dos EUA de 1990, 87% dos norte-americanos podiam ser identificados apenas através do código postal, data de nascimento e sexo.

Segundo a diretora executiva do AI Now Institute da Universidade de Nova York, Amba Kak, a empresa está se baseando em uma “noção muito desatualizada” de que o anonimato é “uma solução mágica para resolver a questão da privacidade”.

Além disso, o tipo de modelo de inteligência artificial da Aware é capaz de fazer suposições precisas através de informações pessoais, como idioma, contexto, gírias e muito mais, de acordo com pesquisas recentes.

“Nenhuma empresa está em posição de dar quaisquer garantias sobre a privacidade e a segurança desses tipos de sistemas”, disse Kak. “Não há ninguém que possa dizer com franqueza que esses desafios estão resolvidos.”

VEJA TAMBÉM - Imposto de Renda 2024: descomplique a sua declaração com a ajuda do nosso Guia de IR totalmente gratuito.

Risco no ambiente de trabalho

Para além da questão da privacidade, Amba Kak vê prejuízo nas relações dentro do local de trabalho.

“Isso resulta em um efeito inibidor sobre o que as pessoas dizem”, disse Kak. “Essas são tanto questões de direitos dos trabalhadores quanto de privacidade.”

Já Jutta Williams, cofundadora da Humane Intelligence, organização sem fins lucrativos sobre responsabilidade de IA, informou que o monitoramento de mensagens por meio de inteligência artificial pode dificultar a possibilidade de defesa do trabalhador.

Em caso de demissões ou punições, a falta de acesso a todos os dados envolvidos impossibilita a defesa.

Williams ainda afirmou que o uso da inteligência artificial para vigilância de funcionários pode ser configurado como “crime de pensamento”.

“Isso é tratar as pessoas como inventário de uma forma que nunca vi”, afirmou à CNBC.

*Com informações da CNBC

Existe idade ideal para virar gestor de equipe?

Liderança não é um cargo, mas um processo contínuo de aprendizado. Independentemente da idade, um gestor precisa reconhecer suas lacunas, buscar suporte e estar disposto a evoluir junto com sua equipe.

Bayer, Ambev e Silimed têm vagas para estágio e trainee com bolsa-auxílio de até R$ 7 mil; confira as oportunidades

Para jovens estudantes e recém-formados em busca de um lugar no mercado de trabalho, o estágio ou trainee certo pode ser a porta de entrada. Com o fim de março se aproximando, empresas brasileiras e multinacionais seguem em busca de talentos para reforçar suas equipes — e essa pode ser a chance de agarrar uma […]

Geração Z será a mais rica da história — mas enfrentará custo de vida alto e mercado de trabalho tensionado

A riqueza dos nascidos entre 1997 e 2012 terá um aumento exponencial em pouco tempo, segundo projeções do Bank of America

Não é um pássaro (nem um avião): Ibovespa tenta manter bom momento enquanto investidores se preparam para a Super Quarta

Investidores tentam antecipar os próximos passos dos bancos centrais enquanto Lula assina projeto sobre isenção de imposto de renda

Inscrições para a Globo acabam nesta sexta (21); confira essas e outras vagas para estágio e trainee com bolsa-auxílio de até R$ 7 mil

Os aprovados nos programas de estágio e trainee devem começar a atuar até o segundo semestre de 2025; as inscrições ocorrem durante todo o ano

Consignado para quem é CLT: o passo a passo do programa que promete baratear o crédito com garantia do FGTS

A estratégia do governo é direta: ampliar o acesso a empréstimos mais baratos e tirar os trabalhadores das armadilhas do superendividamento

Tony Volpon: As três surpresas de Donald Trump

Quem estudou seu primeiro governo ou analisou seu discurso de campanha não foi muito eficiente em prever o que ele faria no cargo, em pelo menos três dimensões relevantes

Essa nova tecnologia chinesa muda tudo o que sabemos até agora sobre inteligência artificial — e não é o DeepSeek

Criada pela startup chinesa Monica, a nova IA está disponível apenas para convidados no momento

Hegemonia em disputa: Ibovespa tenta manter bom momento em semana de IPCA, dados de emprego nos EUA e balanços

Temporada de balanços volta a ganhar fôlego enquanto bolsas têm novo horário de funcionamento, inclusive no Brasil

Mata-mata ou pontos corridos? Ibovespa busca nova alta em dia de PIB, medidas de Lula, payroll e Powell

Em meio às idas e vindas da guerra comercial de Donald Trump, PIB fechado de 2024 é o destaque entre os indicadores de hoje

8 mitos sobre o trabalho que sabotam sua carreira (e como reprogramá-los)

É preciso reconhecer que algumas convicções pré-concebidas atrapalham nossa vida profissional e no ambiente de trabalho, mas é possível mudá-las

Ranking Forbes: Quem são as mulheres mais ricas da América? Veja a brasileira mais bem colocada

Herdeira do fundador da rede Walmart lidera o ranking da Forbes; brasileira mais bem colocada é herdeira do Banco Safra e está no 13º lugar.

NFL volta ao Brasil: liga anuncia partida em São Paulo para temporada 2025; veja quando, onde e quem joga

Partida com os Los Angeles Chargers ocorre em setembro, um ano após estreia da liga no Brasil

Existe ‘luz no fim do túnel’ para Louis Vuitton, Hermès e Gucci? Mercado de luxo deve ter crescimento morno até 2027

Relatório do Business of Fashion (BoF) em parceria com a consultoria McKinsey & Company aponta tendências para o segmento, que vive uma desaceleração desde o ano passado

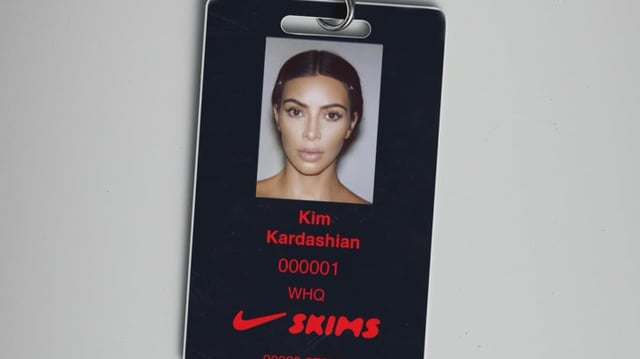

NikeSKIMS: aliança de Nike com Kim Kardashian promete incomodar rivais como a Adidas (e o ex da empresária, Kanye West)

Mais que uma colaboração, aliança apresenta marca inteiramente nova; anúncio chega em fase de expansão da label de Kim Kardashian e como avanço após a chegada do CEO Elliot Hill à Nike

Nomad, Bradesco Seguros e Amil estão com vagas abertas para estágio e trainee; confira estas e outras oportunidades com salário de até R$ 2,5 mil

Os aprovados nos programas de estágio e trainee devem começar a atuar no primeiro semestre de 2025; as inscrições ocorrem durante todo o ano

Cannabis, monopólio do Estado: o plano da Suíça para legalizar o uso recreativo da erva

A aprovação de um parecer na última sexta-feira (14) dá um novo capítulo à política de Cannabis na Suíça; contra o comércio ilegal, texto propõe monopólio do Estado na venda e aplicação de lucros em políticas de combate à dependência

O fim dos copos Stanley? Nova garrafa térmica ameaça sucesso de marca queridinha nos Estados Unidos

Marca, que também é americana, lançou copos com cores exclusivas na rede Target e virou “trend” no TikTok

O urso de hoje é o touro de amanhã? Ibovespa tenta manter bom momento em dia de feriado nos EUA e IBC-Br

Além do índice de atividade econômica do Banco Central, investidores acompanham balanços, ata do Fed e decisão de juros na China

Adeus, ChatGPT? Elon Musk anuncia novo chatbot de IA e promete ser o ‘mais inteligente do mundo’

O anúncio acontece em uma crescente concorrência de empresas no mercado de tecnologia, também de olho no ChatGPT, da Open IA, e na chinesa DeepSeek

SIGA O SD NO WHATSAPP

SIGA O SD NO WHATSAPP